https://mcode.co.kr/video/list2?viewMode=view&idx=92

메타코드M

빅데이터 , AI 강의 플랫폼 & IT 현직자 모임 플랫폼ㅣ메타코드 커뮤니티 일원이 되시기 바랍니다.

mcode.co.kr

메타코드로부터 제공받은 강의를 바탕으로 후기를 작성하고 있습니다.

URL 분석

페이지네이션된 URL의 패턴을 분석하는 것은 웹 크롤링에서 매우 중요합니다. 대부분의 웹사이트는 페이지 번호를 URL의 파라미터로 사용합니다. 예를 들어, ?page=2와 같이 페이지 번호를 나타내는 경우가 많습니다. 이러한 패턴을 파악함으로써, 크롤러가 자동으로 다음 페이지로 이동할 수 있도록 설정할 수 있습니다. URL 구조가 복잡한 사이트의 경우, 개발자 도구를 통해 네트워크 요청을 분석하여 페이지네이션의 동작 방식을 이해하는 것도 좋은 방법입니다.

루프 사용

루프를 사용하여 페이지 번호를 증가시키면서 데이터를 순차적으로 크롤링하는 방법은 효율적인 데이터 수집을 위한 핵심 전략입니다. for 또는 while 루프를 사용하여 페이지 번호를 조절하고, 해당 페이지의 URL을 생성하여 웹 크롤러가 접근할 수 있도록 합니다. 이 과정에서는 반복문의 조건을 적절히 설정하여 모든 페이지를 방문할 수 있도록 주의해야 합니다. 또한, 서버에 부담을 주지 않기 위해 요청 사이에 적절한 딜레이를 두는 것이 좋습니다.

동적 페이지 대응

현대의 많은 웹사이트는 JavaScript를 활용하여 동적으로 콘텐츠를 로딩합니다. 이러한 동적 페이지의 경우, 일반적인 HTML 파싱 방식으로는 데이터를 제대로 추출할 수 없습니다. 따라서, Selenium과 같은 도구를 사용하여 실제 브라우저에서 페이지를 로드하고, 이후에 필요한 데이터를 추출하는 방식이 필요합니다. Selenium을 사용하면, JavaScript가 실행된 이후의 DOM 구조에 접근하여 데이터를 수집할 수 있습니다. 하지만, 실제 브라우저를 사용하기 때문에 속도가 느릴 수 있으므로, 필요한 경우에만 사용하는 것이 좋습니다.

데이터 추출

데이터를 추출하기 위해서는 Beautiful Soup, lxml과 같은 HTML 파싱 라이브러리를 사용합니다. 이 라이브러리들은 HTML 문서의 구조를 분석하여 필요한 데이터를 쉽게 추출할 수 있도록 도와줍니다. 예를 들어, BeautifulSoup를 사용하면 HTML 태그와 클래스 이름을 기반으로 특정 데이터를 찾아낼 수 있습니다. 데이터 추출 과정에서는 웹 페이지의 구조를 잘 이해하는 것이 중요하며, 개발자 도구를 사용하여 원하는 데이터가 위치한 HTML 요소를 찾는 것이 필요합니다.

딕셔너리와 리스트 사용

추출한 데이터를 효율적으로 관리하기 위해서는 딕셔너리와 리스트를 활용하는 것이 좋습니다. 각 페이지에서 크롤링한 데이터를 키-값 쌍의 딕셔너리로 저장하고, 이렇게 생성된 딕셔너리를 리스트에 순차적으로 추가하면, 구조화된 데이터를 손쉽게 관리할 수 있습니다. 이러한 방식은 나중에 데이터를 분석하거나 시각화할 때 매우 유용하며, JSON 형태로 저장하거나, Pandas DataFrame으로 변환하는 것도 간편합니다.

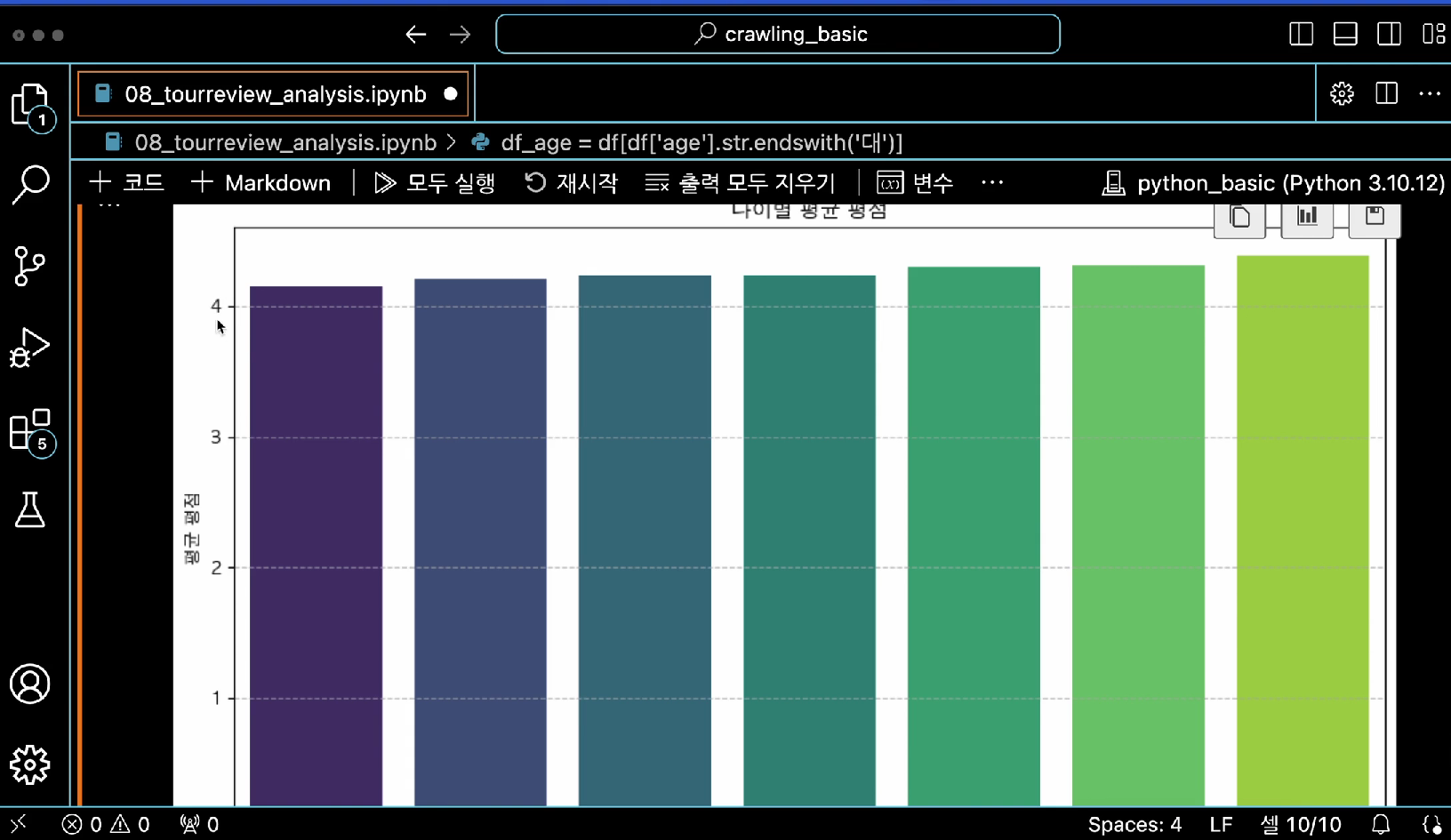

이 강의를 통해 페이지네이션을 활용한 효율적인 데이터 크롤링 방법과, 수집한 데이터의 시각화 및 분석 방법을 배웠습니다. 웹에서 데이터를 수집하고 분석하는 능력은 다양한 분야에서 매우 중요합니다. 이 지식을 바탕으로 실제 프로젝트에 적용해보시기 바랍니다.

크롤링 프로젝트의 확장성 고려

- 코드 최적화: 데이터를 효율적으로 크롤링하기 위해 코드를 최적화하세요. 코드의 재사용성과 유지보수성을 높이는 것이 중요합니다.

- 확장 가능한 구조: 크롤링한 데이터를 다양한 형태로 분석하고 활용할 수 있도록, 데이터를 저장하고 처리하는 구조를 유연하게 설계하세요.

- 새로운 데이터 소스 탐색: 웹 크롤링 기술을 활용하여 다양한 웹사이트나 소셜 미디어 플랫폼에서 새로운 데이터를 수집할 기회를 모색하세요.